Spark大数据分析与实战:基于Spark MLlib 实现音乐推荐_基于spark的音乐

利用AUC评分最高的参数,给用户推荐艺术家对多个用户进行艺术家推荐利用AUC评分最高的参数,给艺术家推荐喜欢他的用户。

·

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

利用AUC评分最高的参数,给用户推荐艺术家

对多个用户进行艺术家推荐

利用AUC评分最高的参数,给艺术家推荐喜欢他的用户

三、实验步骤:

- 安装Hadoop和Spark

- 启动Hadoop与Spark

- 将文件上传到 HDFS

- 实现音乐推荐

四、实验过程:

1、安装Hadoop和Spark

具体的安装过程在我以前的博客里面有,大家可以通过以下链接进入操作:

Hadoop的安装:https://blog.csdn.net/weixin_47580081/article/details/108647420

Scala及Spark的安装:https://blog.csdn.net/weixin_47580081/article/details/114250894

提示:如果IDEA未构建Spark项目,可以转接到以下的博客:

IDEA使用Maven构建Spark项目:https://blog.csdn.net/weixin_47580081/article/details/115435536

2、启动Hadoop与Spark

查看3个节点的进程

master

slave1

slave2

3、将文件上传到 HDFS

Shell命令:

[root@master ~]# cd /opt/data/profiledata\_06-May-2005/

[root@master profiledata\_06-May-2005]# ls

[root@master profiledata\_06-May-2005]# hadoop dfs -put artist\_alias.txt artist\_data.txt user\_artist\_data.txt /spark/input

4、实现音乐推荐

源代码:

package com.John.SparkProject

import org.apache.spark.SparkConf

import org.apache.spark.broadcast.Broadcast

import org.apache.spark.ml.recommendation.{

ALS, ALSModel}

import org.apache.spark.sql.functions._

import org.apache.spark.sql.{

DataFrame, Dataset, SparkSession}

import scala.collection.mutable.ArrayBuffer

import scala.util.Random

/\*\*

\* @author John

\* @Date 2021/5/25 12:49

\*/

object project02 {

def main(args: Array[String]): Unit = {

/\*\*

\* 前期环境配置以及数据准备

\*/

// 创建一个SparkSession对象

val conf = new SparkConf()

.setMaster("local[2]")

.setAppName("Project02\_RecommenderApp")

.set("spark.sql.crossJoin.enabled", "true")

val spark = new SparkSession.Builder()

.config(conf)

.getOrCreate()

import spark.implicits._

// 导入 artist\_data.txt 文件 (每个艺术家的 ID 和对应的名字)

// 字段名分别是: artistid artist\_name

val rawArtistData = spark.read.textFile("hdfs://192.168.254.122:9000/spark/input/artist\_data.txt")

val artistIdDF = transformArtistData(rawArtistData)

val artistIdDFtest = transformArtistData1(rawArtistData)

// 导入 artist\_alias.txt 文件 (将拼写错误的艺术家 ID 或ID 变体对应到该艺术家的规范 ID)

// 字段名分别是: badid goodid

val rawAliasData = spark.read.textFile("hdfs://192.168.254.122:9000/spark/input/artist\_alias.txt")

val artistAlias = transformAliasData(rawAliasData).collect().toMap

// 导入 user\_artist\_data.txt 文件 (用户音乐收听数据)

// 字段名分别是 userid artistid playcount

val rawUserArtistData = spark.read.textFile("hdfs://192.168.254.122:9000/spark/input/user\_artist\_data.txt")

// 整合数据

val allDF = transformUserArtistData(spark, rawUserArtistData, artistAlias)

allDF.persist()

// 拆分训练集和测试集

val Array(trainDF, testDF) = allDF.randomSplit(Array(0.9, 0.1))

trainDF.persist()

// 查看一下指定 user 听过的艺术家

allDF.join(artistIdDFtest,"artist").select("name").filter("user='2093760'").show(5)

/\*\*

\* 根据题目要求参数

\* 给用户推荐艺术家

\*/

// // 根据题目要求构建模型

// val als = new ALS()

// .setSeed(Random.nextLong())

// .setImplicitPrefs(true)

// .setRank(10) // 模型潜在因素个数

// .setRegParam(0.01) // 正则化参数

// .setAlpha(1.0) // 管理偏好观察值的 基线置信度

// .setMaxIter(5) // 最大迭代次数

// .setUserCol("user")

// .setItemCol("artist")

// .setRatingCol("count")

// .setPredictionCol("prediction")

// // 用训练数据训练模型

// val model = als.fit(trainDF)

// // 释放缓存资源

// trainDF.unpersist()

// // 开始推荐

// val userID = 2093760

// val artistNum = 5

// val recommendDF = recommend(model, userID, artistNum, artistIdDF)

//

// val strings = recommendDF.map(\_.mkString("|")).collect()

// println(strings.toBuffer)

/\*\*

\* 计算AUC评分最高的参数

\* 原理:循环指定参数暴力计算,根据AUC计算出评分最高的参数进行建模

\*/

// // 艺术家id数据,用于AUC评分

// val allArtistIds = allDF.select("artist").as[Int].distinct().collect()

// val bAllArtistIds = spark.sparkContext.broadcast(allArtistIds)

//

// // 网格搜索

// val evaluations =

// // 利用for循环,生成不同的超参数配置

// for (rank <- Seq(5, 30);

// regParam <- Seq(4.0, 0.0001);

// alpha <- Seq(1.0, 40.0))

// yield {

// // 构建模型

// val als = new ALS()

// .setSeed(Random.nextLong())

// .setImplicitPrefs(true)

// .setRank(rank)

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

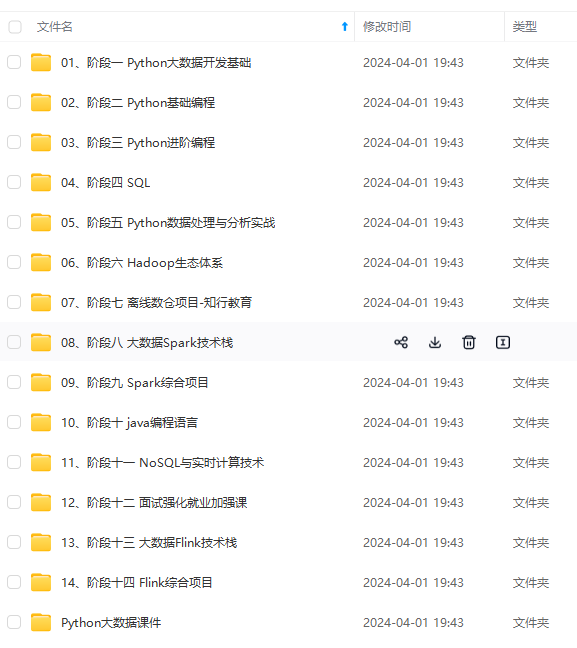

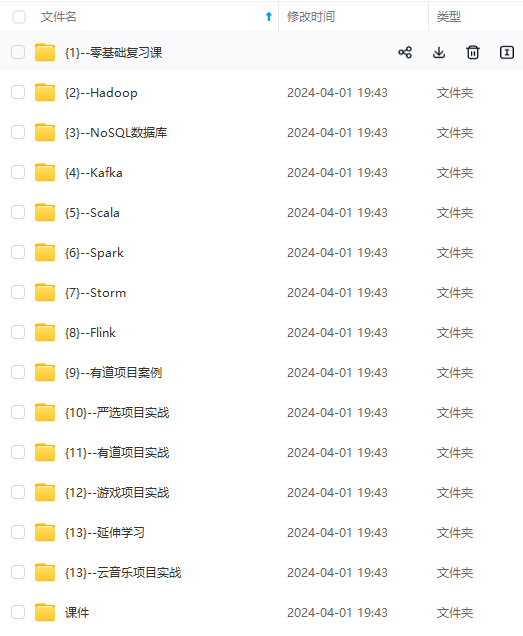

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)