输入三维数据,用sklearn中的非线性支持向量机做三分类,python代码,进行结果的可视化展示(包括决策面和样本点),打印分类结果

在每个迭代步骤中,算法会计算前一个模型的残差(或损失函数的负梯度),并使用这些残差来训练一个新的决策树,然后将这个树加到现有的模型上,以此来减小整体模型的损失。在这个例子中,决策边界是通过一个等值面来表示的,它将三维空间划分为不同的类别区域。请注意,由于三维数据在二维屏幕上的可视化可能比较困难,因此可能需要一些调整来确保可视化结果的可读性。此外,梯度提升决策树通常在二维数据上更容易可视化,因此如果

首先,需要安装 scikit-learn 库。可以使用以下命令来安装:

pip install -U scikit-learn

然后,可以使用以下代码来实现所需的功能:

import numpy as np

import matplotlib.pyplot as plt

from mpl_toolkits.mplot3d import Axes3D

from sklearn.svm import SVC

# 生成随机的三维数据

np.random.seed(0)

n_samples = 100

X = np.random.randn(n_samples, 3)

y = np.zeros(n_samples)

y[X[:, 0] + X[:, 1] + X[:, 2] > 0] = 1

y[X[:, 0] - X[:, 1] + X[:, 2] > 0] = 2

# 训练非线性支持向量机模型

model = SVC(kernel='rbf', C=1.0, random_state=0)

model.fit(X, y)

# 可视化展示

fig = plt.figure()

ax = fig.add_subplot(111, projection='3d')

# 绘制决策面

x_min, x_max = X[:, 0].min() - 1, X[:, 0].max() + 1

y_min, y_max = X[:, 1].min() - 1, X[:, 1].max() + 1

z_min, z_max = X[:, 2].min() - 1, X[:, 2].max() + 1

xx, yy, zz = np.meshgrid(np.arange(x_min, x_max, 0.2),

np.arange(y_min, y_max, 0.2),

np.arange(z_min, z_max, 0.2))

Z = model.predict(np.c_[xx.ravel(), yy.ravel(), zz.ravel()])

Z = Z.reshape(xx.shape)

ax.contour3D(xx, yy, zz, Z, cmap='cool', alpha=0.5)

# 绘制样本点

ax.scatter(X[y == 0, 0], X[y == 0, 1], X[y == 0, 2], c='r', label='Class 0')

ax.scatter(X[y == 1, 0], X[y == 1, 1], X[y == 1, 2], c='g', label='Class 1')

ax.scatter(X[y == 2, 0], X[y == 2, 1], X[y == 2, 2], c='b', label='Class 2')

ax.set_xlabel('X')

ax.set_ylabel('Y')

ax.set_zlabel('Z')

ax.legend()

# 打印分类结果

predicted_labels = model.predict(X)

print("Predicted Labels:", predicted_labels)

plt.show()

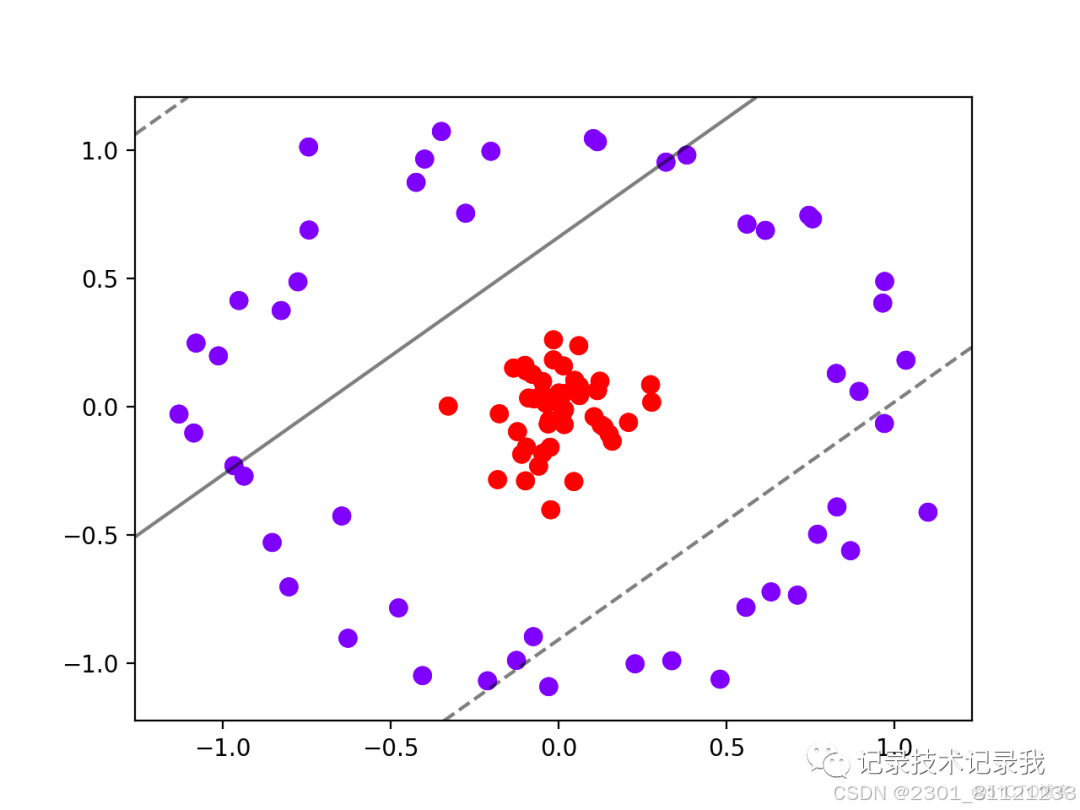

这段代码首先生成了随机的三维数据,然后使用非线性支持向量机进行三分类训练。接着使用 matplotlib 库将决策面和样本点可视化展示出来,并打印了分类结果。

注意:在这个例子中,我们使用了 rbf 核函数,默认参数情况下即为高斯核函数。你也可以根据需要选择其他核函数。

梯度提升决策树(GradientBoostingDecisionTree,GBDT)是一种集成学习算法,它在迭代过程中构建多个决策树以提高模型的性能。在每个迭代步骤中,算法会计算前一个模型的残差(或损失函数的负梯度),并使用这些残差来训练一个新的决策树,然后将这个树加到现有的模型上,以此来减小整体模型的损失。

以下是一个使用Python中的scikit-learn库实现梯度提升决策树分类器的简单示例,并使用matplotlib库进行可视化展示:

```python

importnumpyasnp

fromsklearn.datasetsimportmake_blobs

fromsklearn.model_selectionimporttrain_test_split

fromsklearn.ensembleimportGradientBoostingClassifier

fromsklearn.metricsimportaccuracy_score

importmatplotlib.pyplotasplt

frommpl_toolkits.mplot3dimportAxes3D

#生成三维数据

n_samples=300

n_features=3

centers=np.array([[1,1,1],[1,0,1],[1,-1,1]])

X,y=make_blobs(n_samples=n_samples,centers=centers,n_features=n_features,cluster_std=0.2)

#划分数据集为训练集和测试集

X_train,X_test,y_train,y_test=train_test_split(X,y,test_size=0.2,random_state=42)

#创建GBDT模型

gbdt=GradientBoostingClassifier(n_estimators=100,learning_rate=0.1,max_depth=3)

#训练模型

gbdt.fit(X_train,y_train)

#打印分类结果

print("Trainingaccuracy:",gbdt.score(X_train,y_train))

print("Testaccuracy:",gbdt.score(X_test,y_test))

#可视化数据点

fig=plt.figure()

ax=fig.add_subplot(111,projection='3d')

ax.scatter(X[:,0],X[:,1],X[:,2],c=y,cmap='viridis',edgecolors='k')

#可视化决策边界

defplot_decision_boundary(model,X,y):

#生成网格以可视化决策边界

x_min,x_max=X[:,0].min()-1,X[:,0].max()+1

y_min,y_max=X[:,1].min()-1,X[:,1].max()+1

z_min,z_max=X[:,2].min()-1,X[:,2].max()+1

xx,yy,zz=np.meshgrid(np.arange(x_min,x_max,0.02),

np.arange(y_min,y_max,0.02),

np.arange(z_min,z_max,0.02))

#将网格点转换为输入格式

points=np.c_[xx.ravel(),yy.ravel(),zz.ravel()]

#预测每个网格点的类别

pred=model.predict(points)

#将预测结果重塑为与网格相同的形状

pred=pred.reshape(xx.shape)

#在三维图中绘制决策边界

ax.contour3D(xx,yy,zz,pred,alpha=0.5,cmap='binary')

plot_decision_boundary(gbdt,X,y)

#调整图表属性

ax.set_xlabel('XLabel')

ax.set_ylabel('YLabel')

ax.set_zlabel('ZLabel')

plt.title('GradientBoostingDecisionTreeDecisionBoundary')

plt.show()

```

这段代码首先生成了一个三维数据集,然后使用梯度提升决策树模型对数据进行训练,并打印出训练集和测试集的准确率。最后,它使用`plot_decision_boundary`函数在三维空间中可视化了模型的决策边界。在这个例子中,决策边界是通过一个等值面来表示的,它将三维空间划分为不同的类别区域。

请注意,由于三维数据在二维屏幕上的可视化可能比较困难,因此可能需要一些调整来确保可视化结果的可读性。此外,梯度提升决策树通常在二维数据上更容易可视化,因此如果可能的话,将数据转换为二维可能更有助于可视化。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)